Il primo aprile 2023 il GDPR (General Data Protection Regulation) ha bloccato il trasferimento negli Stati Uniti dei dati degli utenti italiani di OpenAI, che ha sospeso il servizio in Italia generando diverse proteste e accendendo ulteriormente il dibattito sull’uso di ChatGPT. Un mese dopo, il blocco è stato rimosso, lasciando tuttavia sul tavolo molte domande aperte: quali sono le opportunità e i rischi reali di una tecnologia attorno a cui c’è molta mitologia, ma poca conoscenza?

“Ora che le abbiamo dato un nuovo nome, sosterremo ancora l’idea che SALAMI svilupperà una qualche forma di coscienza?” SALAMI è l’arguto acronimo di “Systematic Approaches to Learning Algorithms and Machine Inferences” [Approcci sistematici agli algoritmi di apprendimento e alle inferenze automatiche], una definizione proposta dall’informatico e politico italiano Stefano Quintarelli nel 2019 come un modo più obiettivo e onesto di riferirci a tutto ciò che attualmente chiamiamo Intelligenza Artificiale (IA). Quintarelli è convinto che il primo bias dell’IA sia il suo nome, che implicitamente suggerisce la possibilità che le macchine sviluppino una qualche forma di coscienza, emozioni e personalità, arrivando a superare i limiti dell’umano. Rinunciare al nome che gli diede nel 1956 il matematico americano Marvin Minsky sarebbe dunque il primo passo verso una necessaria demistificazione dell’Intelligenza Artificiale.

Quintarelli è tutt’altro che solo in questa convinzione, e per quanto SALAMI non abbia attecchito, annovera tra i suoi fan figure quali lo scrittore e attivista Cory Doctorow, convinto che l’IA sia “una soluzione in cerca di un problema”, e la linguista computazionale Emily M. Bender, coautrice nel marzo 2021 del paper On the Dangers of Stochastic Parrots1 – che è costato il licenziamento a due membri del team etico di Google, Timnit Gebru e Margaret Mitchell, colpevoli di aver partecipato alla sua stesura. Il pappagallo stocastico è l’animale ipotetico che le autrici del saggio introducono per spiegare i LLM (Large Language Models), il fondamento dell’attuale primavera di SALAMI: sistemi che ricuciono casualmente sequenze di forme linguistiche in base a informazioni probabilistiche su come si combinano, ma senza alcun riferimento al significato. Come i pappagalli, i LLM come ChatGPT non capiscono quello che dicono, perché la loro memoria non si àncora alla realtà ma solo al linguaggio; imitano, ma non hanno accesso al mondo reale né dispongono di una nozione di verità, il che li porta sovente a inventare e “mentire”; avendo accesso a dataset vastissimi e a risorse computazionali altrettanto ingenti, imitano e mentono molto bene; ma proprio questa vastità costituisce, secondo Bender, un pericolo, perché rende impossibile valutare attentamente i dataset utilizzati per il machine learning e ripulirli dei bias razziali e di genere e della disinformazione da cui sono infestati.

Diventa evidente, qui, una delle ricadute più pericolose della mistificazione di SALAMI: che non solo ne cela la vera natura dietro un’immagine seducente, ma ne oblitera anche le reali problematicità, annebbiandoci la vista con paure esagerate: l’avvento della super-intelligenza, la soggezione dell’uomo alla macchina, la singolarità…

Sin dai suoi albori, l’idea di creare macchine che pensano si fonda su una delle idee più perniciose che la storia della tecnologia ci abbia regalato: la metafora computazionale. In breve, il cervello è un computer, e il funzionamento del cervello può essere riprodotto da un computer. Un’idea che, come molti hanno notato, si fonda su una concezione riduttiva dell’intelligenza umana (di cui si trascura in particolare il rapporto con il corpo: l’intelligenza è sempre incorporata), e su una concezione esagerata delle potenzialità della computazione. Per decenni, la storia della rimediazione digitale del pensiero umano procede lentamente, tra primavere e inverni, speranze e disillusioni. La mistificazione, invece, corre veloce; contagia l’immaginario del futuro, pervadendo la fantascienza con sogni di super-intelligenze in grado di soggiogare l’uomo, di ridurlo in schiavitù o di farlo innamorare; infetta gli ingegneri, i guru e gli imprenditori del settore, in gran parte fedeli cultori della singolarità. È pervasiva e insinuante: penetra nel nostro linguaggio e nel modo in cui pensiamo il nostro rapporto con la tecnologia. La ritroviamo nei termini che usiamo quotidianamente per descrivere SALAMI, e persino per criticarla: perché – si è chiesta di recente Naomi Klein – parliamo di “machine hallucination” quando potremmo parlare semplicemente di glitch o di spazzatura algoritmica? Perché diciamo che SALAMI mente, falsifica e costruisce la realtà, quando potremmo semplicemente dire che con quest’ultima non ha alcun rapporto, perché si fonda – notava Ben Davis – su modelli di linguaggio, e non modelli di conoscenza? SALAMI non sogna, non mente, non ci ruba il lavoro, non pensa, e con lei non è possibile costruire alcun tipo di relazione, tanto meno di natura sentimentale. Non ci programma e non ci osserva. Non è una “specie aliena”, come l’ha descritta Geoffrey Hinton, uno dei suoi “padri”, che si è di recente licenziato da Google col pretesto di poter criticare SALAMI apertamente; né è, come sostiene non Donna Haraway, ma una forma deteriore e modaiola di chthulucenismo, una specie sorella con cui “fare famiglia”. Per quanto l’idea possa solleticare la nostra vanità antropocentrica, non è una creatura e non è un dio che ci siamo creati da soli e che ci sconfiggerà; è, piuttosto, un idolo, un vitello d’oro da trattare come fece Mosè.

Il caso di Hinton ci consente di introdurre una forma paradossale di hype, già messa in campo per altre tecnologie, ma che ha raggiunto il parossismo proprio con SALAMI: il criti-hype. Lee Vinsel, il docente del Virginia Tech che ha coniato il termine, lo definisce una forma di critica che nutre l’hype e si nutre di esso, prendendo le rivendicazioni iperboliche di imprenditori e sostenitori e invertendole di segno, ma mantenendo intatta l’esagerazione, il senso che l’innovazione criticata stia preparando un cambiamento straordinario.

In questa fase estrema dell’hype di SALAMI, il criti-hype non sembra più confinato nei programmi di ricerca sull’etica finanziati dalle compagnie – dove l’ha scovato Vinsel – ma diventa un’articolazione schizofrenica delle strategie di comunicazione dei sostenitori di SALAMI: è criti-hype il gesto di Hinton, che esce da Google per dire preoccupato che abbiamo creato un’intelligenza molto più potente della nostra; è criti-hype, oltre che un patetico tentativo di recuperare un po’ di terreno, la lettera aperta “Pause Giant AI Experiments”2, pubblicata nel marzo 2023 e sottoscritta da migliaia di persone, tra cui Elon Musk (già co-fondatore di OpenAI, l’azienda che ha lanciato DALL-E e ChatGPT), scienziati, ricercatori e ingegneri di Amazon, DeepMind, Google, Meta, Microsoft e altre aziende impegnate nella corsa all’oro, per chiedere una pausa di sei mesi in cui regolare “una corsa fuori controllo allo sviluppo e all’impiego di menti digitali sempre più potenti che nessuno – nemmeno i loro creatori – è in grado di comprendere, prevedere o controllare in modo affidabile”3; è criti-hype, infine, la mossa mirabolante di Sam Altman, attuale CEO di OpenAI, che nel maggio 2023 ha chiesto al congresso americano di regolamentare SALAMI, dicendo che potrebbe compromettere le elezioni e che non c’è modo di rimettere il genio nella bottiglia4.

Ovviamente, non c’è nessun genio fuori della bottiglia: ci sono solo aziende che hanno trasferito nel loro prodotto, come ha scritto il filosofo Santiago Zabala, “gli stessi valori distruttivi e pericolosi che guidano il capitalismo predatorio”5, e che cercano di mascherare, presentandolo come un dono, “il furto più grande e devastante della storia dell’umanità”, quello condotto ai danni della totalità della conoscenza umana così come è stata riversata in rete, spiega ancora Klein. Ma in un contesto in cui la mistificazione ha contagiato sia la celebrazione che la critica, ai veri Mosè resta il compito di mostrare la fragilità, la secolarità, la materialità e l’idiozia del vitello d’oro. Alla demistificazione di SALAMI non può bastare un acronimo ridicolo, o altri nomi alternativi come i “pappagalli stocastici” di Bender e i “rendering statistici” di Hito Steyerl. È necessario che arriviamo a comprendere, come ha ribadito di recente anche Jaron Lanier, che non ci troviamo di fronte a una divinità o a qualcosa di magico, incomprensibile e autonomo, ma a uno strumento progettato dall’uomo, frutto di decisioni e responsabilità umane; che, lungi dall’essere il principio di una super-intelligenza, SALAMI è fondamentalmente stupida, priva di ogni capacità di relazionarsi col mondo reale, e capace solo di produrre una simulazione di senso (James Bridle); che il modo in cui sono progettate le reti neurali si fonda su una concezione diminuita di cognizione; che l’apparente magia di SALAMI ha costi enormi, in termini di consumo energetico, inquinamento, privacy, generazione e diffusione di false notizie, manipolazione delle relazioni sociali e dei comportamenti collettivi, espropriazione del lavoro e sfruttamento indiscriminato della produzione culturale, perpetuazione di stereotipi culturali e di pregiudizi razziali e di genere; e che la sua efficacia è espressione di un apparato tecno-sociale congegnato per rendere invisibili, a maggior gloria del mito dell’automazione, gli apparati estrattivi di risorse (materiali e immateriali) e le schiere di lavoratori umani impegnati quotidianamente nelle operazioni di acquisizione dati, tagging e pulizia dei dataset e decine di altri “lavori fantasma”, come li hanno chiamati Mary L. Gray e Siddharth Suri.

L’arte, in questa situazione, non occupa una posizione neutrale. Del resto, la neutralità è un lusso che non può più concedersi dal momento in cui SALAMI l’ha resa “funzionale”, in due modi: usandola indiscriminatamente, insieme a vaste quantità di altri dati (tra cui un’infinità di spazzatura digitale) per il training delle reti neurali; e indicando nella propria presunta capacità di generare arte in modo autonomo la prova estrema che è stato raggiunto un punto critico di non ritorno: del resto, che cosa c’è di più umano dell’arte?

Come altrove, anche nell’arte la strada della mistificazione passa attraverso l’adozione, più o meno consapevole, del mito dell’intelligenza umana, magica o semidivina; l’espropriazione del lavoro artistico inizia dalla sua celebrazione di una mitologia che non ha contribuito a creare. In questo senso, gran parte della “AI Art” è, a tutti gli effetti, arte di regime.

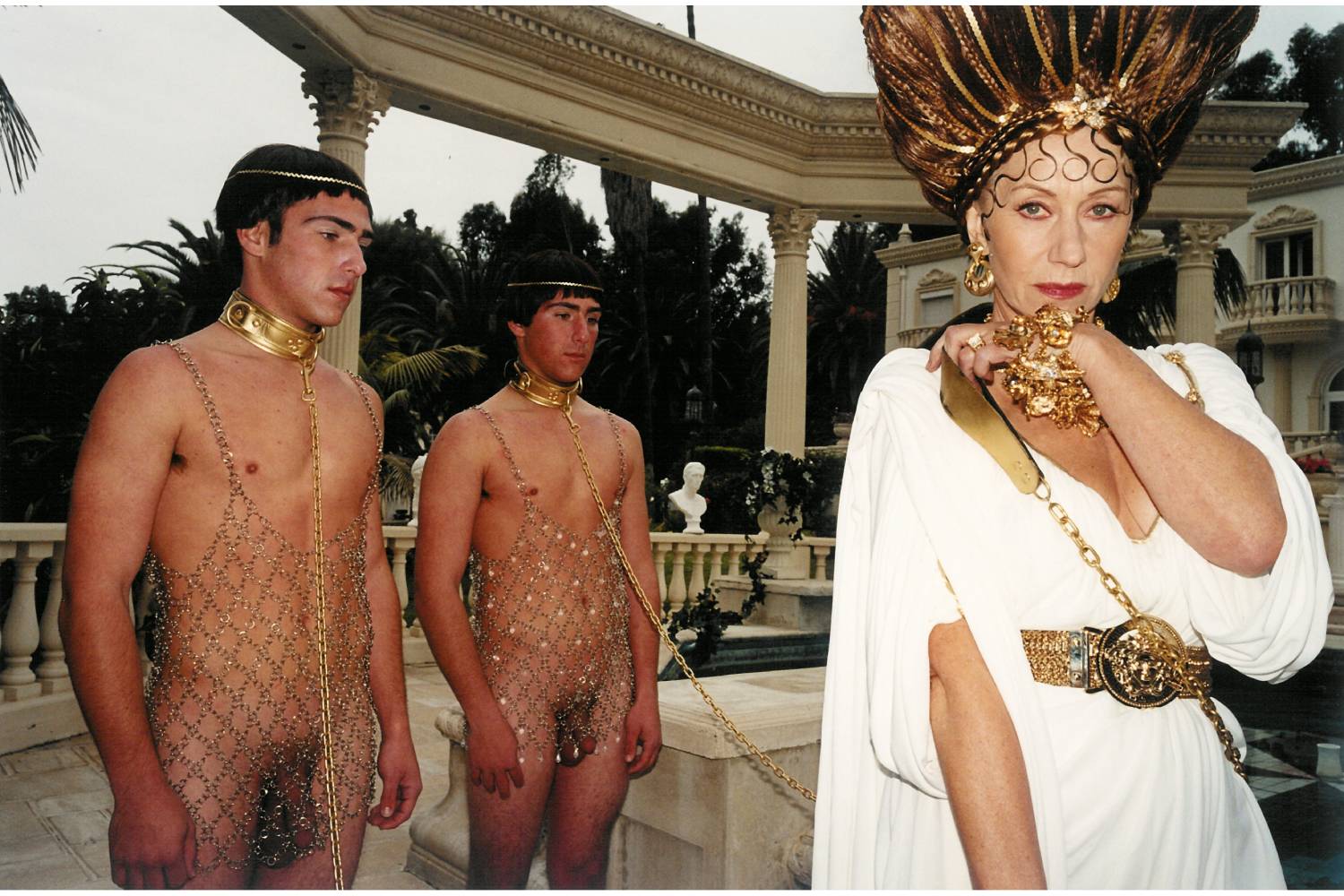

Campioni della mistificazione in arte sono ad esempio il collettivo francese OBVIOUS, che nel 2018 ha messo all’asta, firmandolo con una stringa di codice – e quindi pretestuosamente attribuendone l’autorialità all’algoritmo – un ritratto generato da una GAN scritta da un altro artista (Robbie Barrat) e da loro educata su un dataset di ritratti della tradizione occidentale; o l’artista turco Refik Anadol, non a caso amatissimo dalle compagnie che sviluppano SALAMI (ha vinto, tra l’altro, il Microsoft Research Best Vision Award ed è stato per anni artista in residenza nel programma “Artists and Machine Intelligence” di Google). Anadol progetta per le sue animazioni – che ostentano il “processo creativo”, i “sogni” e le “allucinazioni” della macchina – display monumentali e spettacolari evidentemente ispirati alla tradizione del sacro, di fronte alle quali il pubblico non può che assumere un’attitudine contemplativa e adorante, abbacinato dalla luce, dal colore e dal continuo fluire di quei sogni astratti. In Unsupervised (2022-23), il suo ciclo più recente, Anadol espropria – con il benestare dell’istituzione – l’intera collezione del MoMA di New York, per mostrarcela “vista attraverso la mente di una macchina”.

Abbiamo già fatto riferimento ad alcuni campioni di demistificazione, come Hito Steyerl – che in anni non sospetti parlava di stupidità artificiale – e James Bridle. Fondamentale anche il lavoro, artistico e teorico, sviluppato negli anni da Trevor Paglen, che ha investigato i pregiudizi incorporati nei dataset e ha reso visibile lo sguardo della macchina, e quello di Vladan Joler, che con la complicità di teorici come Kate Crawford e Matteo Pasquinelli ha tradotto in immagini la complessità e stratificazione dell’apparato industriale e umano che rende possibile la magia di SALAMI. Più di recente, alcuni artisti sono entrati nel dibattito sull’uso illegittimo delle immagini come strumenti di training per le reti neurali: Molly Crabapple ha scritto una lettera aperta che ha raccolto migliaia di firme, che descrive l’AI Art generativa come “vampiresca”, e come una scelta economica che non è inevitabile, ma che avrà come inevitabile conseguenza l’impoverimento della nostra cultura; e Holly Herndon, che per parte sua si è creata un “digital twin” educato sulla sua voce, con il compagno Mat Dryhurst ha messo a punto uno strumento software che aiuta artisti e illustratori a identificare i furti e a esercitare il proprio diritto di opt out.

In The Future of Something (2023), un video recente dell’artista svedese Jonas Lund, un’umanità che si percepisce sull’orlo del “technological takeover” si riunisce in sessioni di gruppo per condividere il proprio disagio e immaginare il proprio futuro. La personalizzazione di SALAMI inquina tutta la conversazione, ma sono gli atteggiamenti manipolatori di alcuni partecipanti ad aprire le prospettive più preoccupanti. Come sempre nella storia dell’uomo, non è dello strumento che abbiamo creato e della sua autonomia e personalità che dobbiamo avere paura, ma dell’uso che ne faremo, come creatori o come utenti.